Nous utilisons des cookies pour vous fournir l'ensemble de nos services, notamment la recherche et les alertes. En acceptant, vous consentez à notre utilisation de ces cookies.

Choisir mes préférences

Depuis fin 2022, l’IA n’est plus un sujet innovation. C’est devenu un outil de production : RH, service client, marketing, analyse de données, relation commerciale. L’IA générative n’a pas seulement accéléré la technologie : elle a accéléré les usages. Et mécaniquement… les risques.

L’Union européenne a donc dégainé un cadre inédit : le règlement (UE) 2024/1689, plus connu sous le nom d’AI Act. Le texte encadre le développement, la mise sur le marché et l’utilisation des systèmes d’IA, avec une logique proche du RGPD : créer de la confiance, harmoniser les règles dans le marché unique, et rendre les acteurs responsables, y compris hors UE dès lors que leurs systèmes sont utilisés en Europe.

Pour les entreprises, la question n’est plus “pour ou contre”. Elle est très pragmatique : quels outils IA j’utilise (ou je vends), dans quelle catégorie de risque ils tombent, et quelles obligations je dois être capable de prouver. Décryptage.

Sommaire

L’AI Act n’est pas sorti d’un chapeau bruxellois. Il est le résultat de trois années de négociations, accélérées par l’irruption de l’IA générative et l’explosion des usages. Derrière ce texte, une question très politique, et très économique : comment laisser l’IA se déployer sans transformer le marché en Far West réglementaire ?

Recrutement, crédit, assurance, orientation, triage médical, justice, surveillance… L’intelligence artificielle intervient désormais au cœur de décisions sensibles : elle classe, filtre, hiérarchise, parfois arbitre. À ce niveau-là, une erreur ou un biais ne reste pas un problème technique : c’est un enjeu juridique, social et économique.

Pour exemple, Amazon a abandonné un outil de recrutement basé sur l’IA après avoir constaté qu’il défavorisait les candidatures féminines (biais appris à partir des données historiques). Source : Reuters.

L’IA générative a fait sauter les barrières d’entrée. En quelques mois, des outils capables de produire du texte, des images ou du code se sont retrouvés au cœur des organisations, souvent sans gouvernance, sans documentation, et avec des zones grises (droits d’auteur, données personnelles, deepfakes).

En 2024, 65 % des organisations interrogées déclaraient déjà utiliser régulièrement l’IA générative. Source : McKinsey (The State of AI).

Tous les systèmes d’IA n’exposent pas au même niveau de risque. L’Europe a donc choisi une approche graduée :

Le texte vise une IA dite digne de confiance : plus robuste, plus transparente, mieux supervisée. L’enjeu n’est pas d’empêcher l’innovation, mais d’éviter que l’IA se développe au prix de la discrimination, de la manipulation, ou d’une automatisation aveugle de décisions à fort impact.

« Le présent règlement vise à promouvoir l’adoption d’une intelligence artificielle (IA) axée sur l’humain et digne de confiance […]. » (Règlement (UE) 2024/1689, article 1)

Cette stratégie n’est pas nouvelle. Le RGPD a déjà servi de modèle : un standard européen harmonisé, imposé à tous les acteurs du marché unique. Et il a été appliqué immédiatement : dès la première année, les autorités de protection des données de l’EEE avaient enregistré plus de 144 000 demandes et plus de 89 000 notifications de violations de données.

Preuve qu’un règlement européen n’est pas qu'un cadre théorique : il déclenche du contrôle, des obligations et des preuves à produire, exactement la logique de l’AI Act.

Une idée reçue circule encore : « l’AI Act vise surtout les géants de la tech ». En réalité, le règlement couvre toute la chaîne de valeur de l’IA, de la mise sur le marché à l’usage en entreprise. Il ne concerne pas seulement ceux qui développent l’IA, mais aussi ceux qui la commercialisent, la distribuent ou la déploient dans des processus sensibles.

Le règlement distingue plusieurs catégories d’acteurs, regroupées sous le terme d’« opérateurs ». Dans la pratique, quatre familles sont particulièrement concernées :

Une portée extraterritoriale

L’AI Act fonctionne sur une logique extraterritoriale : une entreprise située hors UE est concernée dès lors que son système d’IA est mis sur le marché européen ou que ses résultats sont utilisés dans l’Union (AI Act, article 2 - Champ d’application).

Cette définition est déterminante : c’est elle qui permet de trancher si votre outil entre (ou non) dans le champ du règlement.

Un système d’IA est « un système automatisé qui est conçu pour fonctionner à différents niveaux d’autonomie et peut faire preuve d’une capacité d’adaptation après son déploiement, et qui, pour des objectifs explicites ou implicites, déduit, à partir des entrées qu’il reçoit, la manière de générer des sorties telles que des prédictions, du contenu, des recommandations ou des décisions qui peuvent influencer les environnements physiques ou virtuels » (Règlement (UE) 2024/1689, article 3 — Définitions).

Donc, un système d’IA, au sens du règlement, correspond à un outil capable de :

En conséquence, dès lors qu’un logiciel analyse des données pour proposer ou trancher, et pas uniquement exécuter une règle prédéfinie, il peut relever de la définition d’un système d’IA.

Voici quelques exemples d’outils généralement considérés (ou non) comme des systèmes d’IA au sens du règlement.

| Catégorie | Exemples | À retenir |

|---|---|---|

| Généralement considéré comme un système d’IA |

|

Ces outils analysent des données pour produire des recommandations, contenus ou décisions. |

| Pas automatiquement une IA au sens du règlement |

|

Ces outils appliquent des règles prédéfinies sans inférence autonome. |

À retenir

Dès qu’un outil apprend, infère, recommande ou classe avec une logique autonome, il peut entrer dans le champ de l’AI Act : il faut alors évaluer son niveau de risque et identifier les obligations associées.

Tout l’AI Act repose sur un principe : toutes les IA ne présentent pas le même niveau de risque. Le règlement ne traite donc pas l’intelligence artificielle en bloc. Il classe les systèmes selon leur impact potentiel sur la santé, la sécurité et les droits fondamentaux, et adapte les règles en conséquence : interdiction, obligations strictes, obligations de transparence… ou simple incitation aux bonnes pratiques.

Le règlement trace une ligne rouge. Certains usages sont considérés comme incompatibles avec les valeurs européennes : ils sont interdits, car jugés trop dangereux ou trop attentatoires aux droits fondamentaux.

| Techniques manipulatrices et trompeuses | Exploitation des vulnérabilités | Prédiction d’infractions sur profilage | Moissonnage d’images faciales | Biométrie à distance en temps réel |

|---|---|---|---|---|

| Techniques subliminales, manipulatrices ou trompeuses visant à altérer substantiellement le comportement d’une personne ou d’un groupe. | Exploitation des vulnérabilités liées à l’âge, au handicap ou à la situation sociale et économique, avec un effet préjudiciable. | Évaluation/prédiction du risque de commission d’infractions pénales uniquement sur la base du profilage, traits de personnalité ou caractéristiques. | Constitution de bases de données de reconnaissance faciale par collecte non ciblée d’images (internet, vidéosurveillance). | Identification biométrique à distance en temps réel dans les espaces accessibles au public, sauf exceptions strictement encadrées. |

Deuxième étage de la fusée : le haut risque. Ici, le règlement n’interdit pas : il encadre lourdement.

Un système est considéré à haut risque lorsqu’il est utilisé dans des domaines où une erreur, un biais ou une défaillance peut avoir des conséquences graves : sécurité, accès à l’emploi, services essentiels, droits fondamentaux.

L’annexe III cite notamment des usages dans :

| Emploi & travailleurs | Éducation & formation | Infrastructures critiques | Services essentiels | Biométrie & identification | Migration & frontières | Application de la loi & justice |

|---|---|---|---|---|---|---|

| Tri de CV, classement de candidatures, outils d’évaluation automatisée, scoring de performance. | Évaluation, orientation, admission, accès à un établissement, affectation de parcours. | Systèmes impactant la sécurité dans les transports, l’énergie, l’eau, les réseaux essentiels. | Scoring de solvabilité et crédit, évaluation de risque, tarification d’assurance (selon cas). | Reconnaissance biométrique, identification, vérification d’identité, catégorisation. | Traitement des demandes (asile, visas), évaluation de risques, contrôle aux frontières. | Analyse de risques, détection d’infractions, aide à la décision dans certains volets judiciaires. |

À ce stade, les entreprises concernées doivent être capables de démontrer : gestion des risques, gouvernance des données, documentation technique, traçabilité, supervision humaine, robustesse, cybersécurité… bref, une conformité par la preuve.

Troisième niveau : les systèmes à risque limité. Ici, le cœur n’est pas la conformité technique, mais l’information.

Le règlement impose notamment :

L'enjeu étant de permettre à l’utilisateur de prendre une décision éclairée.

La majorité des systèmes d’IA utilisés aujourd’hui relèvent de ce niveau : filtres antispam, IA de jeux vidéo, outils de recommandation basiques, automatisations sans impact sensible…

Pour ces systèmes, le règlement n’impose pas d’obligations lourdes. En revanche, il encourage des démarches volontaires : codes de conduite, bonnes pratiques de transparence, documentation minimale, etc.

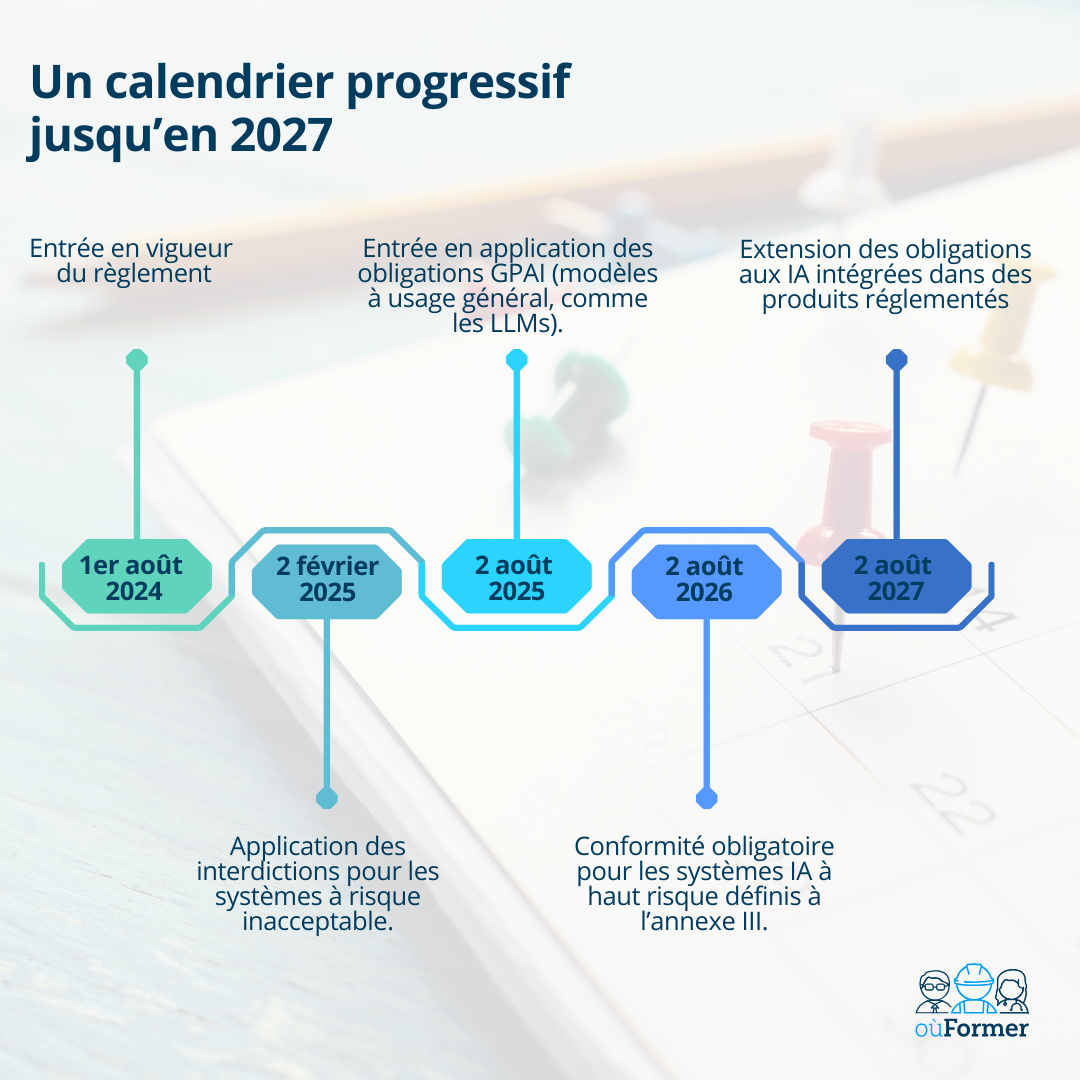

L’AI Act est déjà entré en vigueur, mais il ne s’applique pas en une fois. Le règlement prévoit une mise en œuvre progressive, avec plusieurs échéances qui déclenchent des interdictions ou des obligations selon les cas d’usage.

Chaque échéance déclenche des interdictions ou des obligations. Voici ce que cela implique, date par date, pour les entreprises.

| 2 février 2025 | 2 août 2025 | 2 août 2026 | 2 août 2027 |

|---|---|---|---|

| Interdiction des pratiques à risque inacceptable (art. 5) Manipulation, exploitation de vulnérabilités, moissonnage d’images faciales, biométrie à distance en temps réel dans l’espace public (sauf exceptions strictes). Implication entreprise : arrêter/retirer les usages interdits. |

Modèles d’IA à usage général (GPAI / LLM) Entrée en application des obligations spécifiques (documentation, transparence, respect du droit d’auteur). Implication entreprise : exigences renforcées côté fournisseurs → critères d’achat et contrats à adapter. |

Systèmes d’IA à haut risque (annexe III) Exigences structurantes : gestion des risques, gouvernance des données, documentation technique, logs, traçabilité, supervision humaine, robustesse, cybersécurité. Implication entreprise : conformité démontrable (preuves, dossiers, process). |

Extension aux IA intégrées dans des produits réglementés Application des obligations aux systèmes haut risque intégrés dans des produits (dispositifs médicaux, machines, jouets…). Implication entreprise : articulation AI Act + conformité produit (marquage CE, exigences sectorielles). |

Bacs à sable réglementaires : la carte innovation du règlement

Les bacs à sable réglementaires (AI regulatory sandboxes) sont prévus par l’AI Act afin de permettre le développement, l’entraînement, la mise à l’essai et la validation de systèmes d’IA dans un cadre supervisé (Règlement (UE) 2024/1689, articles 57 et 58).

L’AI Act prévoit des amendes administratives (article 99) avec trois plafonds principaux :

PME / start-up

Le règlement prévoit un mécanisme plus proportionné : le plafond d’amende retenu correspond au montant le plus faible entre le forfait (ex. 35 M€) et le pourcentage du chiffre d’affaires mondial (ex. 7 %).

Sources officielles utilisées

Les informations réglementaires présentées dans ce contenu sont fondées sur les textes en vigueur à la date de mise à jour. Elles peuvent évoluer au fil des actes d’exécution, lignes directrices et publications officielles. Cet article a été rédigé par l’équipe éditoriale oùFormer, spécialiste des formations réglementaires et de la conformité en entreprise.

Infos

Trouver le bon CACESComprendre l'habilitation éléctriqueMentions légalesConditions d'utilisationNous utilisons des cookies pour vous fournir l'ensemble de nos services, notamment la recherche et les alertes. En acceptant, vous consentez à notre utilisation de ces cookies.

Choisir mes préférences